概述

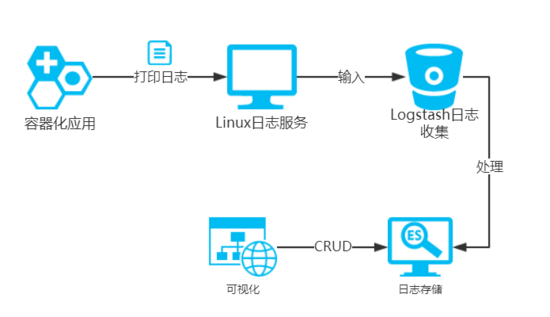

應用一旦容器化以后,需要考慮的就是如何采集位于docker容器中的應用程序的打印日志供運維分析。典型的比如springboot應用的日志 收集。本文即將闡述如何利用elk日志中心來收集容器化應用程序所產生的日志,并且可以用可視化的方式對日志進行查詢與分析,其架構如下圖所示:

架構圖

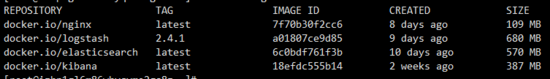

鏡像準備

鏡像準備

- elasticsearch鏡像

- logstash鏡像

- kibana鏡像

- nginx鏡像(作為容器化應用來生產日志)

開啟linux系統rsyslog服務

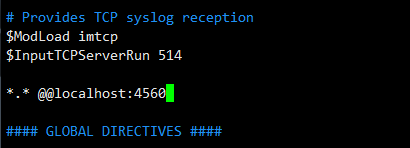

修改rsyslog服務配置文件:

|

1

|

vim /etc/rsyslog.conf |

開啟下面三個參數:

|

1

2

3

4

|

$modload imtcp$inputtcpserverrun 514*.* @@localhost:4560 |

開啟3個參數

意圖很簡單:讓rsyslog加載imtcp模塊并監聽514端口,然后將rsyslog中收集的數據轉發到本地4560端口!

然后重啟rsyslog服務:

|

1

|

systemctl restart rsyslog |

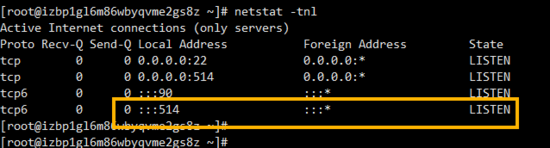

查看rsyslog啟動狀態:

|

1

|

netstat -tnl |

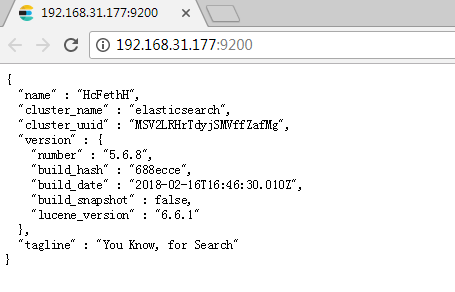

部署elasticsearch服務

|

1

2

3

|

docker run -d -p 9200:9200 \ -v ~/elasticsearch/data:/usr/share/elasticsearch/data \ --name elasticsearch elasticsearch |

es啟動成功效果

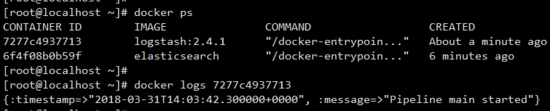

部署logstash服務

添加 ~/logstash/logstash.conf 配置文件如下:

|

1

2

3

4

5

6

7

8

9

10

11

12

|

input { syslog { type => "rsyslog" port => 4560 }}output { elasticsearch { hosts => [ "elasticsearch:9200" ] }} |

配置中我們讓logstash從本地的rsyslog服務中取出應用日志數據,然后轉發到elasticsearch數據庫中!

配置完成以后,可以通過如下命令來啟動logstash容器:

|

1

2

3

4

5

|

docker run -d -p 4560:4560 \-v ~/logstash/logstash.conf:/etc/logstash.conf \--link elasticsearch:elasticsearch \--name logstash logstash \logstash -f /etc/logstash.conf |

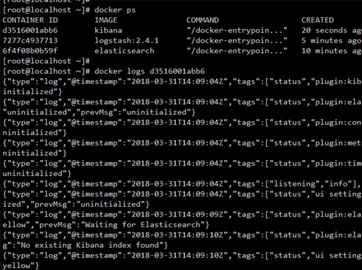

部署kibana服務

|

1

2

3

4

|

docker run -d -p 5601:5601 \--link elasticsearch:elasticsearch \-e elasticsearch_url=http://elasticsearch:9200 \--name kibana kibana |

啟動nginx容器來生產日志

|

1

2

3

|

docker run -d -p 90:80 --log-driver syslog --log-opt \syslog-address=tcp://localhost:514 \--log-opt tag="nginx" --name nginx nginx |

很明顯docker容器中的nginx應用日志轉發到本地syslog服務中,然后由syslog服務將數據轉給logstash進行收集。

至此,日志中心搭建完畢,目前一共四個容器在工作:

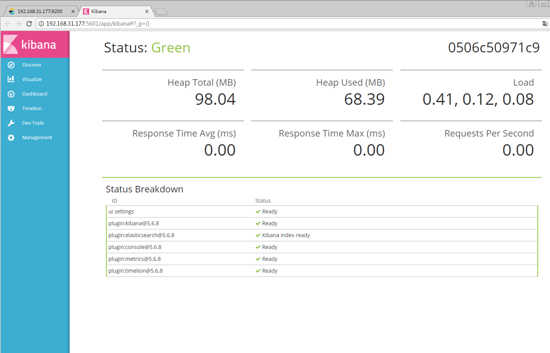

實驗驗證

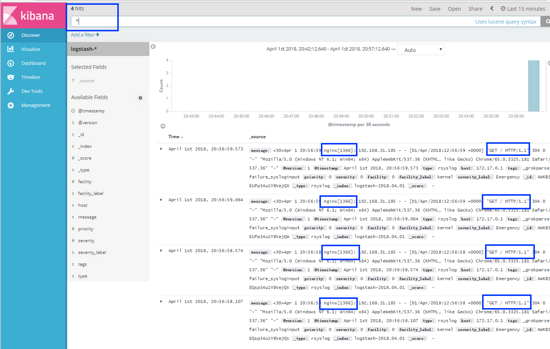

瀏覽器打開 localhost:90 來打開nginx界面,并刷新幾次,讓后臺產生get請求的日志

打開kibana可視化界面: localhost:5601

localhost:5601

收集nginx應用日志

收集nginx應用日志

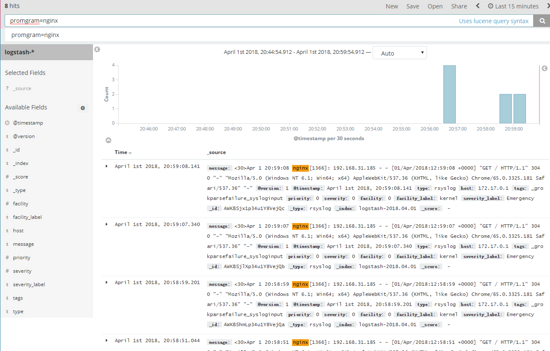

查詢應用日志

在查詢框中輸入 program=nginx 可查詢出特定日志

查詢應用日志

以上就是本文的全部內容,希望對大家的學習有所幫助,也希望大家多多支持服務器之家。

原文鏈接:https://www.jianshu.com/p/a40c36beee63