網站的SEO優化過程中不免會分析網站日志,網站日志的分析和診斷就像給網站看病一樣,我們通過網站日志的分析,可以更加清楚的知道網站的健康狀況,使用這些數據更有利于開展網站SEO優化。網絡管理員如果想在企業的大型網絡中掌握網絡性能,離不開對網絡日志的分析,幫助你在網絡性能出現問題時,及早發現。

通過網站日志可以清楚的得知用戶在什么IP、什么時間、用什么操作系統、什么瀏覽器、什么分辨率顯示器的情況下訪問了你網站的哪個頁面,是否訪問成功。對于專業從事搜索引擎優化工作者而言,網站日志可以記錄各搜索引擎蜘蛛機器人爬行網站的詳細情況,例如:哪個IP的百度蜘蛛機器人在哪天訪問了網站多少次,訪問了哪些頁面,以及訪問頁面時返回的HTTP狀態碼。

為什么需要日志分析工具?

連接到網絡的每個設備或應用都會創建日志文件。網絡管理員使用這些日志文件來查看性能數據。這些工具很有用,因為它們提供了對用戶本來不具備的數據的訪問權限。日志分析工具從設備的日志文件中收集數據,并將其轉換為易于閱讀的格式。在日志分析工具中,以圖形將性能的相關數據顯示到儀表盤。以這種集中格式,讀取性能數據要比嘗試直接讀取日志文件作為文本文件容易得多。

常見的蜘蛛名稱:

Baiduspider:百度蜘蛛

Baiduspider-Image:百度圖片蜘蛛

Googlebot:谷歌機器人

Googlebot-Image:谷歌圖片機器人

360Spider:360蜘蛛

sogou spider:搜狗蜘蛛

一、網站日志的作用

1、通過網站日志可以了解蜘蛛對網站的基本爬取情況,可以知道蜘蛛的爬取軌跡和爬取量。

2、網站的更新頻率也和網站日志中蜘蛛抓取的頻率有關,一般來說更新頻率越高,蜘蛛的抓取頻率越高,而我們網站的更新不僅僅只是新內容的添加同時還有我們的微調操作。

3、我們可以根據網站日志的反應情況,對我們的空間的某些事情和問題提前進行預警,因為服務器如果出問題的話在網站日志中會第一時間反映出來,要知道服務器的穩定速度和打開速度兩者都會直接影響我們的網站。

4、通過網站日志我們可以知道網站的那些頁面是很受蜘蛛歡迎的,而哪些頁面是蜘蛛連碰都不去碰的,同時我們還能發現有一些蜘蛛由于是過度爬取對我們的服務器資源損耗是很大的,我們要進行屏蔽工作。

二、如何下載網站日志

1、首先我們的空間要支持網站日志下載,這一點是很重要的,在購買空間時候需事先了解下是否支持日志下載,因為有的服務商是不提供這項服務的,如果支持的話空間后臺一般都有日志WebLog日志下載這個功能把它下載到根目錄在用FTP傳到本地就可以,服務器的話可以設置將日志文件下載到指定路徑。

2、這里有個很重要的問題,網站日志強烈建議設置成每小時生成一次,小型的企業站和頁面內容較少的網站可以設置成一天,它默認是一天,如果內容多或者大型站設置成一天生成一次,那么一天只生成一個文件,這個文件會相當的大,我們有時電腦打開是會造成死機,設置的話找空間商協調設置即可。

三、網站日志數據分析

1、網站日志中數據量過大,所以我們一般需要借助網站日志分析工具來查看。常用的日志分析工具有:光年日志分析工具、web log exploer、WPS表格等

117.26.203.167 - - [02/May/2011:01:57:44 -0700] "GET/index.PHPHTTP/1.1" 500 19967 "-" "Mozilla/4.0 (compatible; MSIE 8.0;Windows NT 5.1; Trident/4.0; AskTbCS-ST/5.11.3.15590; .NET CLR 2.0.50727; Alexa Toolbar)"

分析:

117.26.203.167訪問ip;

02/May/2011:01:57:44 -0700訪問日期 -時區;

GET/index.php HTTP/1.1根據HTTP/1.1協議抓取(域名下)/index.php這個頁面(GET表示服務器動作);

500服務器響應狀態碼;

服務器響應狀態碼通常狀態碼有以下幾種:200,301,302,304,404,500等。200代表用戶成功的獲取到了所請求的文件,如果是搜索引擎,則證明蜘蛛在這次爬行中順利的發現了一些新的內容。而301則代表用戶所訪問的某個頁面url已經做了301重定向(永久性)處理,302則是暫時性重定向。404則代表所訪問的頁面已經不存在了,或者說訪問的url根本就是個錯誤的。500則是服務器的錯誤。

19967表示抓取了19967個字節;

Mozilla/4.0 (compatible; MSIE 8.0; Windows NT 5.1; Trident/4.0; AskTbCS-ST/5.11.3.15590; .NET CLR 2.0.50727; Alexa Toolbar表示訪問者使用火狐瀏覽器及Alexa Toolbar等訪問端信息;

2、如果你的日志里格式不是如此,則代表日志格式設置不同。

3、很多日志里可以看到 200 0 0和200 0 64則都代表正常抓取。

4、抓取頻率是通過查看每日的日志里百度蜘蛛抓取次數來獲知。抓取頻率并沒有一個規范的時間表或頻率數字,我們一般通過多日的日志對比來判斷,當然,我們希望百度蜘蛛每日抓取的次數越多越好。

5、有時候我們的路徑不統一出現帶斜杠和不帶斜杠的問題,蜘蛛會自動識別為301跳轉到帶斜杠的頁面,這里我們就發現了搜索引擎是可以判斷我們的目錄的,所以我們要對我們的目錄進行統一。

6、我們分析日志分析時間長了,我們能夠看出蜘蛛的抓取規律,同一目錄下面的單個文件的抓取頻率間隔和不同目錄的抓取頻率間隔都可以看出來,這些抓取頻率間隔時間是蜘蛛根據網站權重和網站更新頻率來自動確定的。

7、蜘蛛對于我們的頁面的抓取是分等級的,是根據權重依次遞減的,一般順序為首頁、目錄頁、內頁。

四、通過網站日志我們能知道什么?

1、我們買的空間是否能夠穩定?

2、蜘蛛對我們的那些頁面比較喜歡而對哪些不喜歡?

3、蜘蛛什么時候抓取我們的網站頻繁,我們需要什么時候更新內容?

總結:所以不管是新站還是老網站,不管你做百度還是Google我們都能通過網站日志分析出來搜索引擎蜘蛛抓取的情況;如果網站長時間收錄有問題,那么我們也可以對比網站日志中的搜索引擎蜘蛛行為,來了解網站是哪方面出了問題;如果網站被封,或者被K,我們都可以通過觀察網站日志的情況來了解原因出在什么地方。我們要看的網站日志的分析和診斷就像給網站看病一樣,我們通過網站日志的分析,可以簡單明了的就知道網站的健康狀況,可以利于我們更好的做網站優化,所以對于真正的SEO高手而言,分析蜘蛛日志是最直觀,最有效的額。

服務器日志分析軟件或者在線工具,都是根據我們常用的WEB環境導出或者在線生成的LOG日志文件,然后進行的可視化數據分析。會區別開各個時間節點,訪客、爬蟲的行為,有些基礎的用戶可能在需要的時候看看LOG日志文件就可以,如果深入分析的話會需要一款輔助的日志分析工具。

五、網站日志分析工具推薦

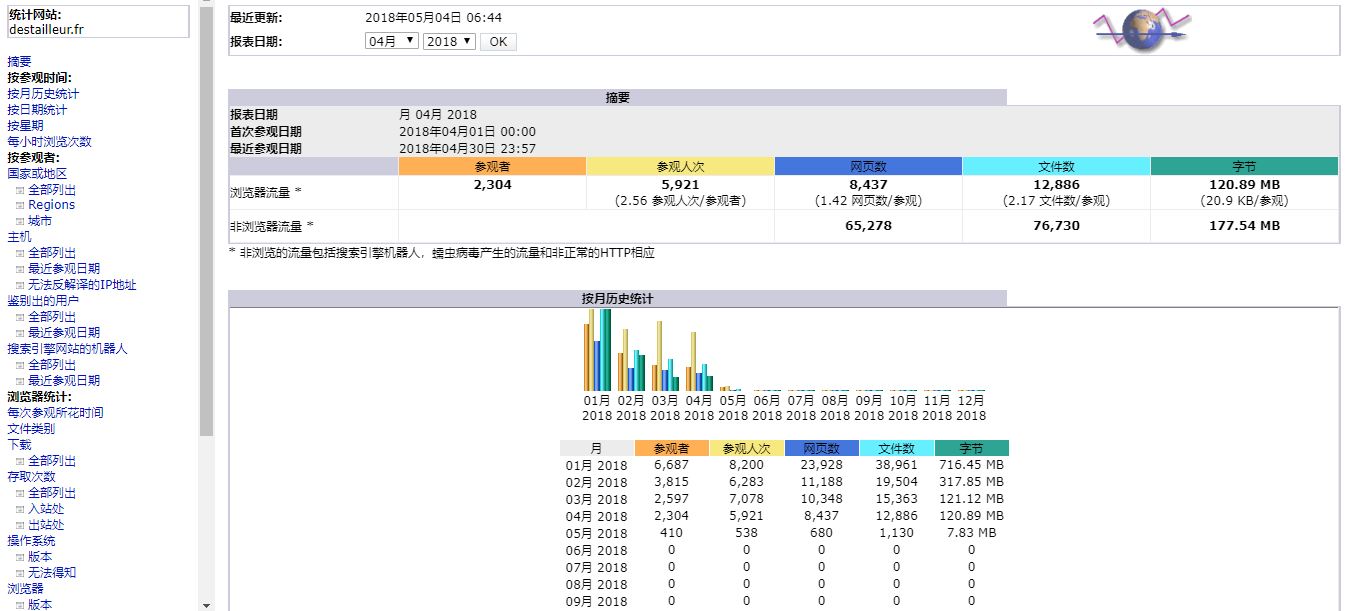

1、Webalizer

Webalizer,采用C語言編寫的,具有很高的運行效率,每秒鐘可以分析10000條數據記錄。有人進行測試過,如果分析40M的日志文件,只需要十幾秒。Webalizer日志工具是一款高效的、免費的web服務器日志分析程序。

Webalizer日志工具會將分析結果以HTML文件格式保存,我們可以很方便的通過web進行瀏覽,webalizer支持標準的一般日志文件格式(Common Logfile Format)。

2、GoAccess

GoAccess,一款來自國外的免費開源可部署在服務器端實現實時日志分析的工具。而且GoAccess日志分析可以實現實時可視化WEB顯示,這個優秀的交互功能比有些僅僅是數據化顯示更為體驗友好。GoAccess可以實現WEB瀏覽器端HTML、CSV、JSON報告,比較適合有需要強化運維能力和數據分析的項目。

GoAccess采用C語言編寫,可實現毫秒級的更新,支持Apache, Nginx, Amazon S3, Elastic Load Balancing, CloudFront等WEB日志格式。可以實現漂亮的終端以及 bootstrap 風格控制面板。在這篇文章中,筆者就和大家一起探索GoAccess日志軟件的部署和功能。

一款可視化 Web 日志分析工具,通過Web 瀏覽器或者nix 系統下的終端程序即可訪問。能為系統管理員提供快速且有價值的 HTTP 統計,并以在線可視化服務器的方式呈現。

官網地址:https://www.goaccess.cc/

3、Analog

Analog,也是一款用來快速處理日志的開源日志分析工具。同樣具有很高的效率,不過這款工具生成的日志結果不夠美觀,analog可以讀取gz格式壓縮的日志文件,并且支持讀取多個文件。Analog下載安裝和進行必要配置后,直接運行analog即可,也可以指定相應的啟動參數來改變輸出文件的內容塊。一般地,會使用crontab來設置一個指定的時間去運行該程序。

4、LOGalyze

LOGalyze,一款來自國外的面向用戶的開源服務器日志和監控日志工具。支持Windows和Linux系統,可以用于收集數據之后,然后針對程序搜索找到所需要的信息。一般這款工具國外的使用的多,但是感覺不是太適合我們國內用戶的使用習慣。

LOGalyze 配置過程也稍微復雜一些,然后我們在 LOGalyze 的 Web 界面中,運行動態報告,并將其導出到 Excel 文件、PDF 文件或其他格式。這些報告結果是基于 LOGalyze 后端管理的多維統計信息。

5、Papertrail

Papertrail,是一款Windows系統的日志分析軟件工具。軟件可以支持自動掃描日志數據。Papertrail掃描日志數據時,可以選擇希望掃描結果顯示的信息。例如,可以選擇掃描是否包含IP地址,電子郵件地址, GUID/UUID,HTTP(s)URL,域,主機,文件名和引用文本等。

6、360星圖

一款非常好用的網站訪問日志分析工具,可以有效識別Web漏洞攻擊、CC攻擊、惡意爬蟲掃描、異常訪問等行為。一鍵自動化分析,輸出安全分析報告,支持iis/apache/nginx日志,支持自定義格式。

下載地址:https://wangzhan.qianxin.com/activity/xingtu

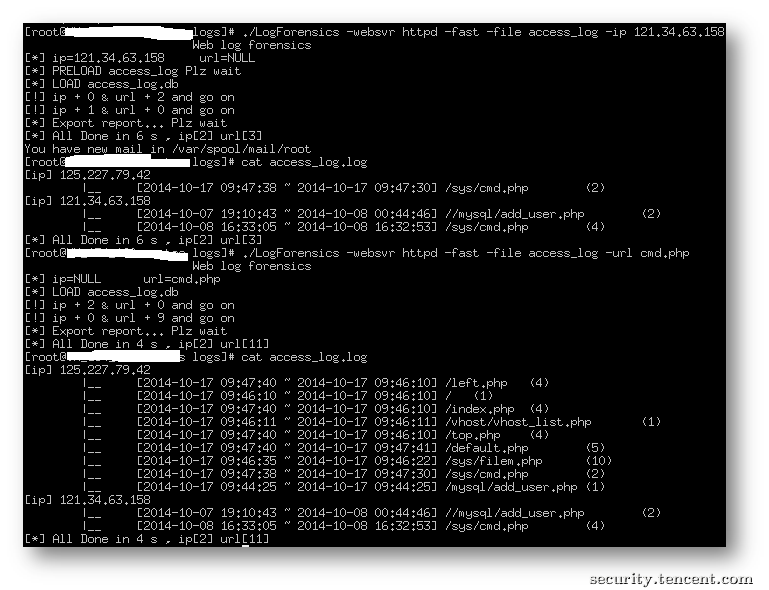

7、LogForensics

TSRC提供的一款日志分析工具,可從單一可疑線索作為調查起點,遍歷所有可疑url(CGI)和來源IP。

相關下載地址:https://security.tencent.com/index.php/opensource/detail/15

8、AWStats

一款功能強大的開源日志分析系統,可以圖形方式生成高級Web,流媒體,ftp或郵件服務器統計信息。

官網地址:http://www.awstats.org/

9、Logstalgia

一款非常炫酷且可視化日志分析工具,可以直觀的展示CC攻擊和網站的日志分析,并以可視化的3D效果展示出來。

下載地址:http://www.softpedia.com/get/Internet/Servers/Server-Tools/Logstalgia.shtml

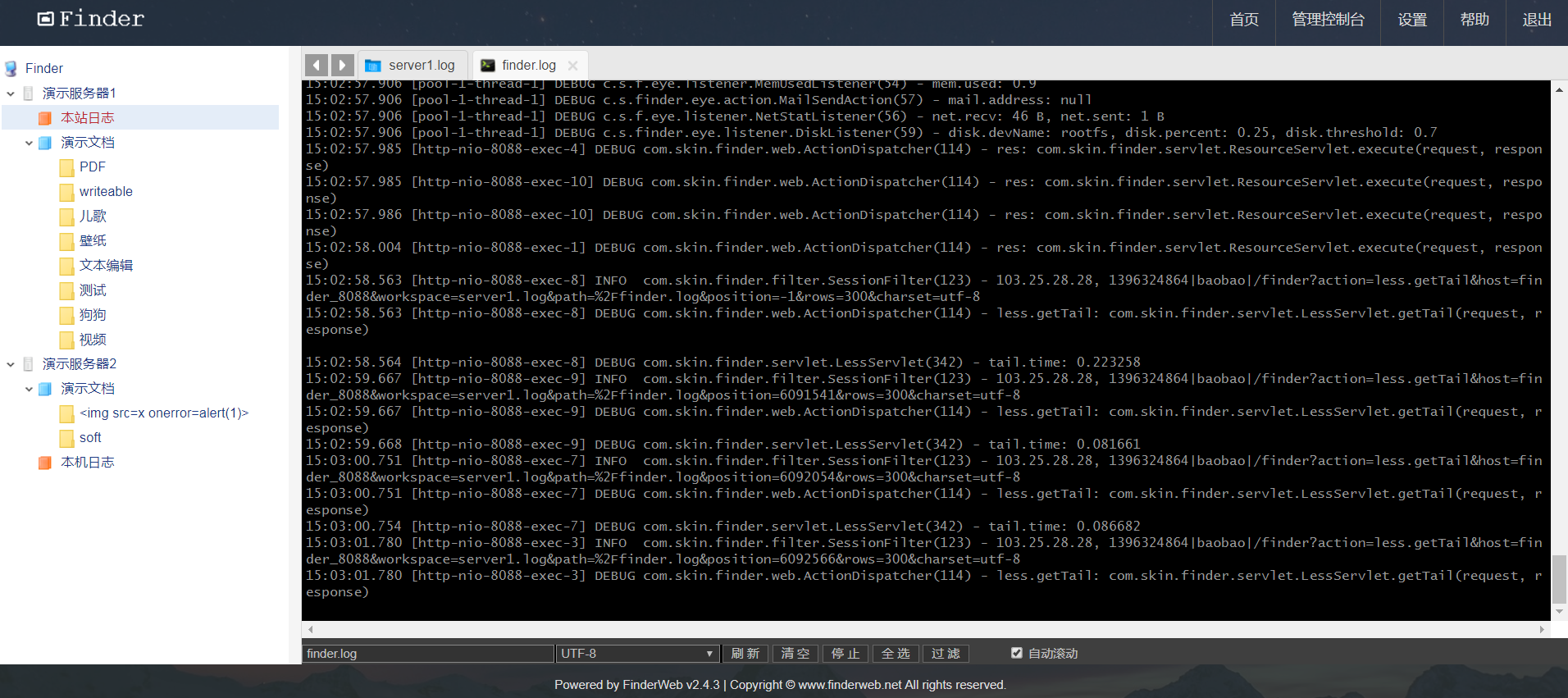

10、FinderWeb

程序員的看日志利器,支持,tail, less, grep,支持超大的文本文件,從幾M到幾十G的日志文件都流暢自如。

下載使用:http://www.finderweb.net/download.html

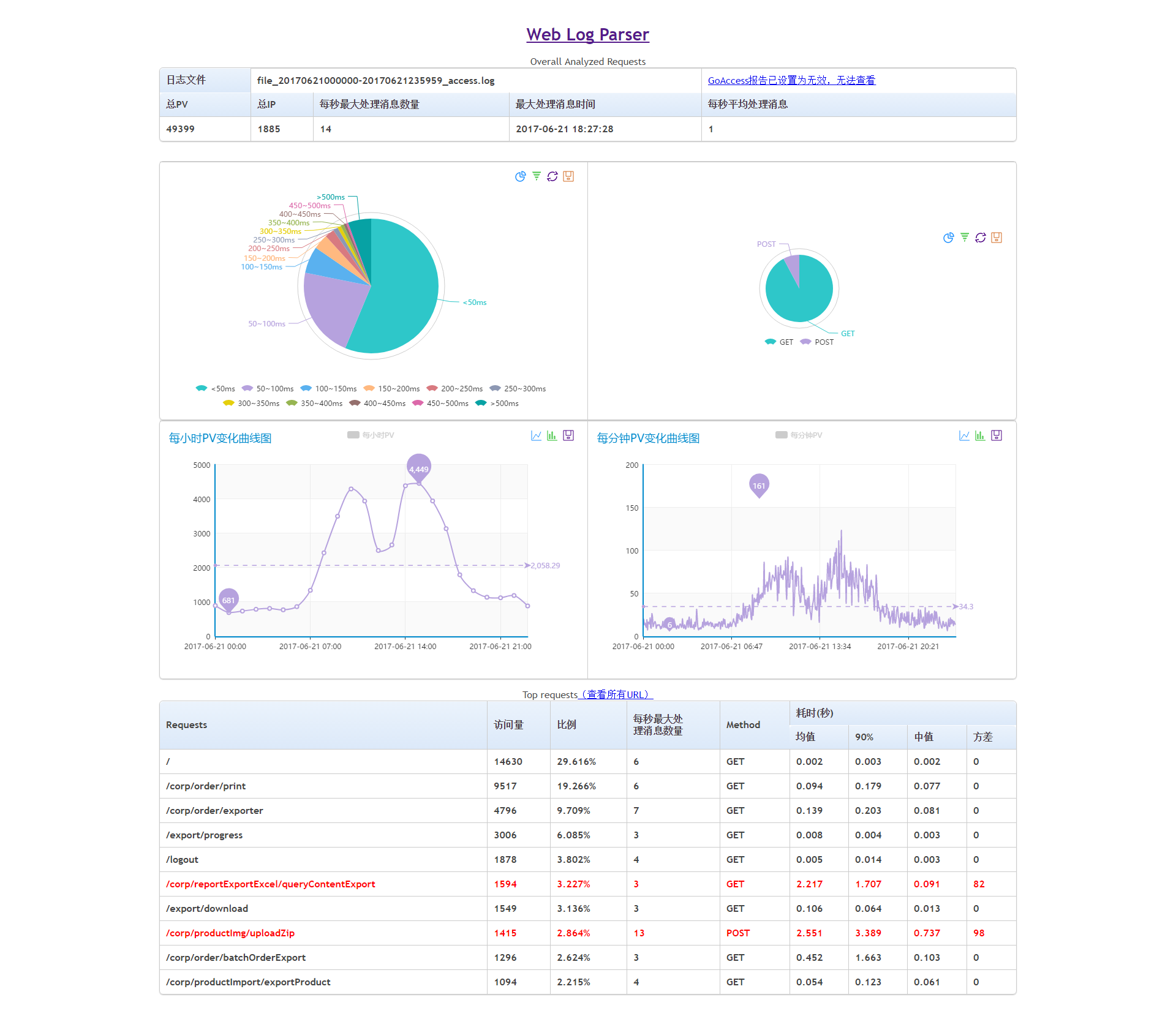

11、web-log-parser

一款開源的分析web日志工具,采用python語言開發,具有靈活的日志格式配置。

github項目地址:https://github.com/JeffXue/web-log-parser

12、ELK

開源實時日志分析的ELK平臺,由ElasticSearch、Logstash和Kiabana三個開源項目組成,在企業級日志管理平臺中十分常見。

下載使用:https://www.elastic.co/cn/elastic-stack

13、Splunk

一款頂級的日志分析軟件,如果你經常用 grep、awk、sed、sort、uniq、tail、head 來分析日志,那么你可以很容易地過渡到Splunk。

下載地址:https://www.splunk.com/zh-hans_cn/download/splunk-enterprise.html

14、IBM QRadar

Qradar有一個免費的社區版本,功能上和商用版本差別不大,適合小規模日志和流量分析使用。

下載地址:https://developer.ibm.com/qradar/ce/

總結,我們一般站長也很少日常去分析日志,即便需要使用也是在出現故障的時候去看。不過目前也有一些WEB環境自帶插件是支持可用日志分析的,比如會看看搜索引擎爬蟲的日志和用戶行為日志。