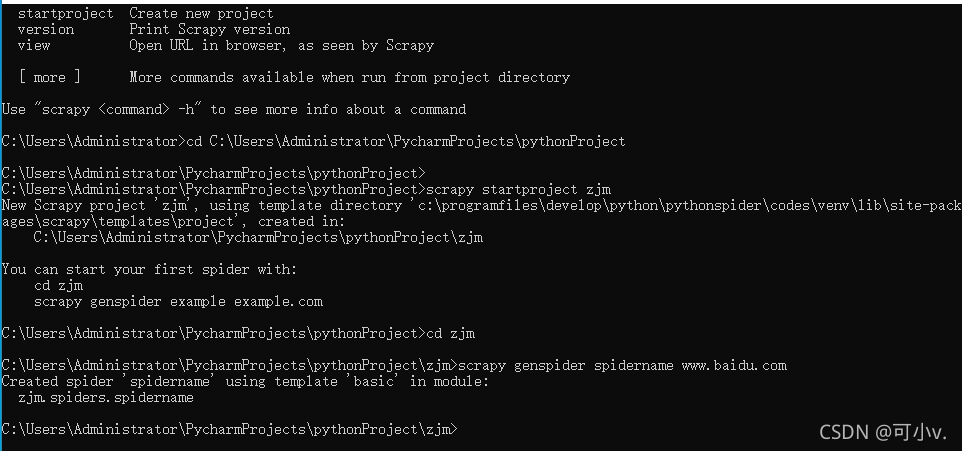

1.在pycharm下安裝scrapy函數庫 2.將安裝好scrapy函數庫下的路徑配置到系統path的環境變量中 3.打開cmd終端輸入:scrapy.exe檢查是否安裝成功 4.創建一個項目:scrapy startproject 項目名字 5.cd進入該目錄下,創建一個spider:scrapy genspider 項目名字 網址 6.編輯settings.py文件中的USER_AGENT選項為正常的瀏覽器頭部 7.執行這個spider:scrapy crawl 項目名字 8.如果遇到因pip版本太低導致安裝不了scarpy函數庫,可以先在cmd窗口輸入py -m pip install --upgrade pip升級命令(前提是你的python環境下得有pip,可通過輸入pip命令查看是否已安裝,如未安裝得去官網下載并解壓至相應路徑)

代碼示例命令截圖:

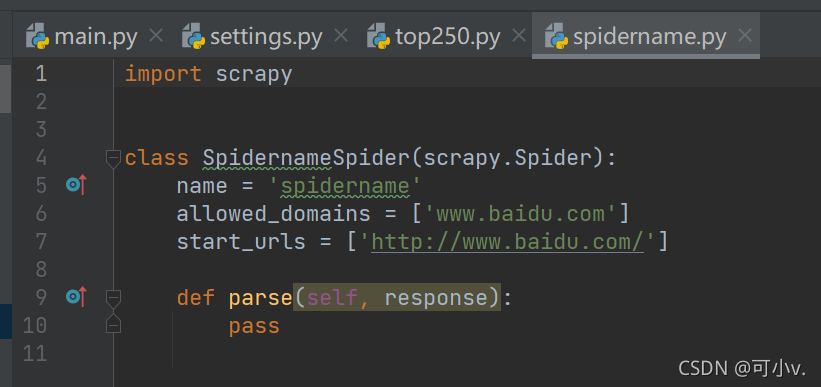

項目文件截圖:

settings.py文件截圖:(需要修改爬取網站的USER_AGENT)

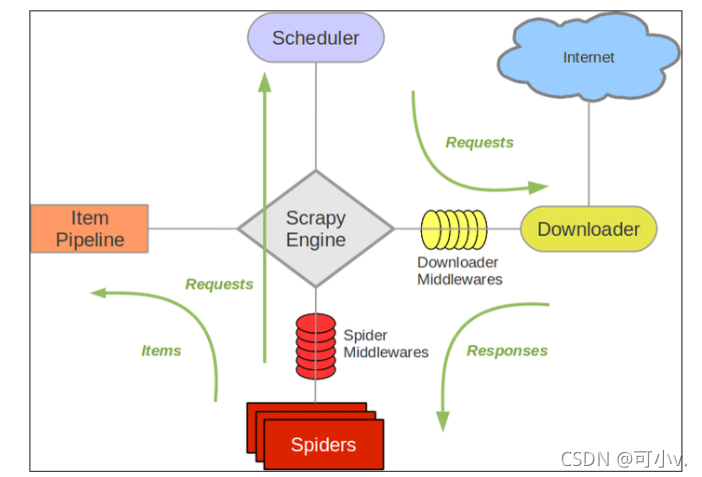

scrapy運行工作流程圖:

Spiders(爬蟲):它負責處理所有Responses,從中分析提取數據,獲取Item字段需要的數據,并將需要跟進的URL提交給引擎,再次進入Scheduler(調度器)

Engine(引擎):負責Spider、ItemPipeline、Downloader、Scheduler中間的通訊,信號、數據傳遞等。

Scheduler(調度器):它負責接受引擎發送過來的Request請求,并按照一定的方式進行整理排列,入隊,當引擎需要時,交還給引擎。

Downloader(下載器):負責下載Scrapy Engine(引擎)發送的所有Requests請求,并將其獲取到的Responses交還給Scrapy Engine(引擎),由引擎交給Spider來處理

ItemPipeline(管道):它負責處理Spider中獲取到的Item,并進行進行后期處理(詳細分析、過濾、存儲等)的地方.

Downloader Middlewares(下載中間件):你可以當作是一個可以自定義擴展下載功能的組件。

Spider Middlewares(Spider中間件):你可以理解為是一個可以自定擴展和操作引擎和Spider中間

通信的功能組件(比如進入Spider的Responses;和從Spider出去的Requests)

總結

本篇文章就到這里了,希望能夠給你帶來幫助,也希望您能夠多多關注服務器之家的更多內容!

原文鏈接:https://blog.csdn.net/qq_62037643/article/details/121502999