BCELoss

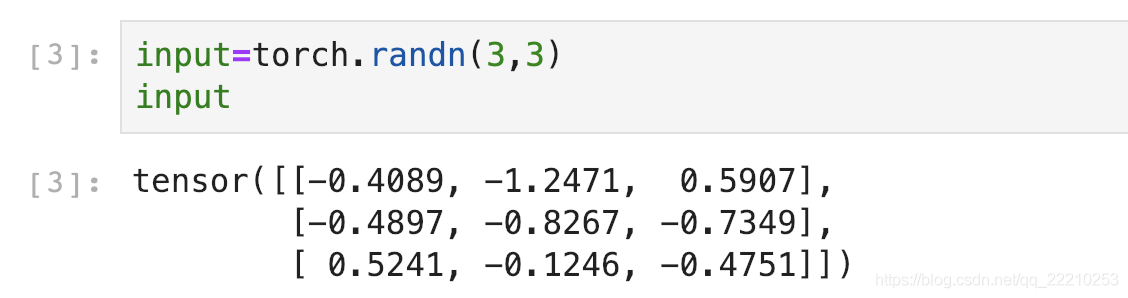

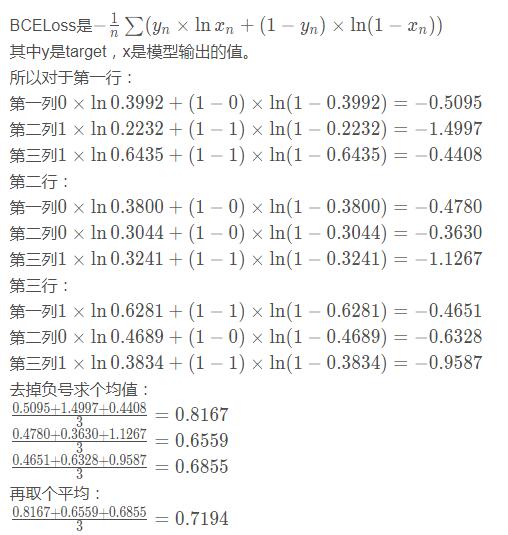

在圖片多標簽分類時,如果3張圖片分3類,會輸出一個3*3的矩陣。

先用Sigmoid給這些值都搞到0~1之間:

假設Target是:

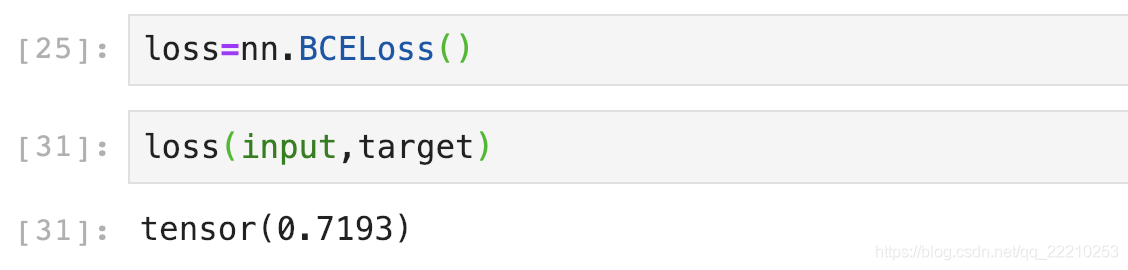

下面我們用BCELoss來驗證一下Loss是不是0.7194!

emmm應該是我上面每次都保留4位小數,算到最后誤差越來越大差了0.0001。不過也很厲害啦哈哈哈哈哈!

BCEWithLogitsLoss

BCEWithLogitsLoss就是把Sigmoid-BCELoss合成一步。我們直接用剛剛的input驗證一下是不是0.7193:

嘻嘻,我可真是太厲害啦!

補充:Pytorch中BCELoss,BCEWithLogitsLoss和CrossEntropyLoss的區別

BCEWithLogitsLoss = Sigmoid+BCELoss

當網絡最后一層使用nn.Sigmoid時,就用BCELoss,當網絡最后一層不使用nn.Sigmoid時,就用BCEWithLogitsLoss。

(BCELoss)BCEWithLogitsLoss

用于單標簽二分類或者多標簽二分類,輸出和目標的維度是(batch,C),batch是樣本數量,C是類別數量,對于每一個batch的C個值,對每個值求sigmoid到0-1之間,所以每個batch的C個值之間是沒有關系的,相互獨立的,所以之和不一定為1。

每個C值代表屬于一類標簽的概率。如果是單標簽二分類,那輸出和目標的維度是(batch,1)即可。

CrossEntropyLoss用于多類別分類

輸出和目標的維度是(batch,C),batch是樣本數量,C是類別數量,每一個C之間是互斥的,相互關聯的,對于每一個batch的C個值,一起求每個C的softmax,所以每個batch的所有C個值之和是1,哪個值大,代表其屬于哪一類。如果用于二分類,那輸出和目標的維度是(batch,2)。

補充:Pytorch踩坑記之交叉熵(nn.CrossEntropy,nn.NLLLoss,nn.BCELoss的區別和使用)

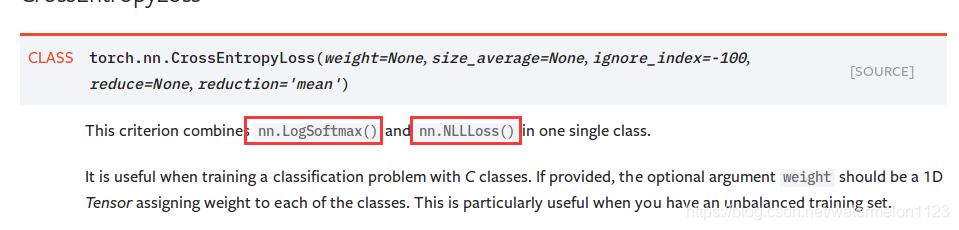

在Pytorch中的交叉熵函數的血淚史要從nn.CrossEntropyLoss()這個損失函數開始講起。

從表面意義上看,這個函數好像是普通的交叉熵函數,但是如果你看過一些Pytorch的資料,會告訴你這個函數其實是softmax()和交叉熵的結合體。

然而如果去官方看這個函數的定義你會發現是這樣子的:

哇,竟然是nn.LogSoftmax()和nn.NLLLoss()的結合體,這倆都是什么玩意兒啊。再看看你會發現甚至還有一個損失叫nn.Softmax()以及一個叫nn.nn.BCELoss()。我們來探究下這幾個損失到底有何種關系。

nn.Softmax和nn.LogSoftmax

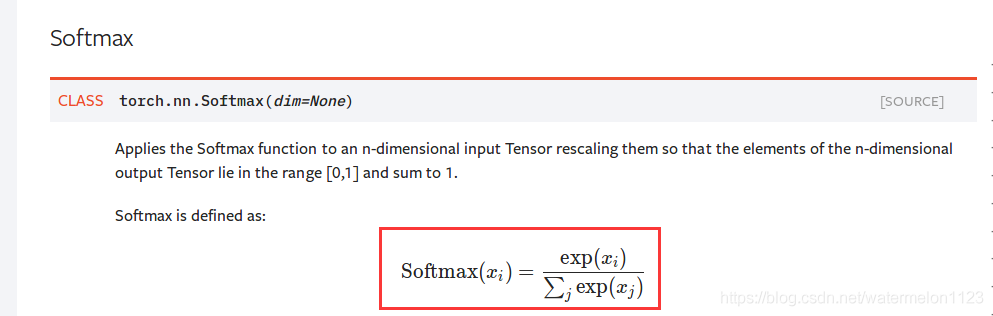

首先nn.Softmax()官網的定義是這樣的:

嗯...就是我們認識的那個softmax。那nn.LogSoftmax()的定義也很直觀了:

果不其然就是Softmax取了個log。可以寫個代碼測試一下:

import torch import torch.nn as nn a = torch.Tensor([1,2,3]) #定義Softmax softmax = nn.Softmax() sm_a = softmax=nn.Softmax() print(sm) #輸出:tensor([0.0900, 0.2447, 0.6652]) #定義LogSoftmax logsoftmax = nn.LogSoftmax() lsm_a = logsoftmax(a) print(lsm_a) #輸出tensor([-2.4076, -1.4076, -0.4076]),其中ln(0.0900)=-2.4076

nn.NLLLoss

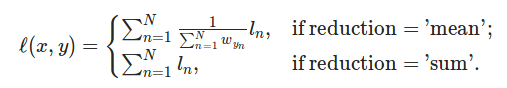

上面說過nn.CrossEntropy()是nn.LogSoftmax()和nn.NLLLoss的結合,nn.NLLLoss官網給的定義是這樣的:

The negative log likelihood loss. It is useful to train a classification problem with C classes

負對數似然損失 ,看起來好像有點晦澀難懂,寫個代碼測試一下:

import torch import torch.nn a = torch.Tensor([[1,2,3]]) nll = nn.NLLLoss() target1 = torch.Tensor([0]).long() target2 = torch.Tensor([1]).long() target3 = torch.Tensor([2]).long() #測試 n1 = nll(a,target1) #輸出:tensor(-1.) n2 = nll(a,target2) #輸出:tensor(-2.) n3 = nll(a,target3) #輸出:tensor(-3.)

看起來nn.NLLLoss做的事情是取出a中對應target位置的值并取負號,比如target1=0,就取a中index=0位置上的值再取負號為-1,那這樣做有什么意義呢,要結合nn.CrossEntropy往下看。

nn.CrossEntropy

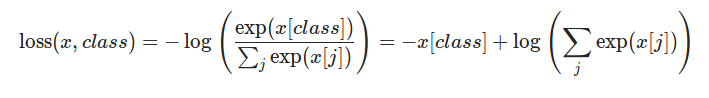

看下官網給的nn.CrossEntropy()的表達式:

看起來應該是softmax之后取了個對數,寫個簡單代碼測試一下:

import torch import torch.nn as nn a = torch.Tensor([[1,2,3]]) target = torch.Tensor([2]).long() logsoftmax = nn.LogSoftmax() ce = nn.CrossEntropyLoss() nll = nn.NLLLoss() #測試CrossEntropyLoss cel = ce(a,target) print(cel) #輸出:tensor(0.4076) #測試LogSoftmax+NLLLoss lsm_a = logsoftmax(a) nll_lsm_a = nll(lsm_a,target) #輸出tensor(0.4076)

看來直接用nn.CrossEntropy和nn.LogSoftmax+nn.NLLLoss是一樣的結果。為什么這樣呢,回想下交叉熵的表達式:

其中y是label,x是prediction的結果,所以其實交叉熵損失就是負的target對應位置的輸出結果x再取-log。這個計算過程剛好就是先LogSoftmax()再NLLLoss()。

------------------------------------

所以我認為nn.CrossEntropyLoss其實應該叫做softmaxloss更為合理一些,這樣就不會誤解了。

nn.BCELoss

你以為這就完了嗎,其實并沒有。還有一類損失叫做BCELoss,寫全了的話就是Binary Cross Entropy Loss,就是交叉熵應用于二分類時候的特殊形式,一般都和sigmoid一起用,表達式就是二分類交叉熵:

直覺上和多酚類交叉熵的區別在于,不僅考慮了 的樣本,也考慮了

的樣本,也考慮了 的樣本的損失。

的樣本的損失。

總結

nn.LogSoftmax是在softmax的基礎上取自然對數nn.NLLLoss是負的似然對數損失,但Pytorch的實現就是把對應target上的數取出來再加個負號,要在CrossEntropy中結合LogSoftmax來用BCELoss是二分類的交叉熵損失,Pytorch實現中和多分類有區別

Pytorch是個深坑,讓我們一起扎根使用手冊,結合實踐踏平這些坑吧暴風哭泣。

以上為個人經驗,希望能給大家一個參考,也希望大家多多支持服務器之家。

原文鏈接:https://blog.csdn.net/qq_22210253/article/details/85222093