最近學習go,爬取網站數據用到正則表達式,做個總結;

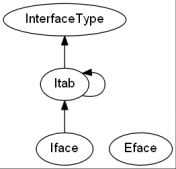

Go中正則表達式采用RE2語法(具體是啥咱也不清楚);

字符

- . ——匹配任意字符 e.g: abc. 結果: abcd,abcx,abc9;

- [] ——匹配括號中任意一個字符 e.g: [abc]d 結果:ad,cd,1d;

- - ——[-]中表示范圍 e.g: [A-Za-z0-9];

- ^ ——[^]中表示除括號中的任意字符 e.g:[^xy]a 結果:aa,da,不能為xa,ya;

數量限定

- ? ——前面單元匹配0或1次;

- + ——前面單元匹配1或多次;

- * ——前面單元匹配0或多次;

- {,} ——顯示個數上下線;e.g : ip地址——[0-9]{1,3}.[0-9]{1,3}.[0-9]{1,3}.[0-9]{1,3};

其他

- \ ——轉義字符;

- | ——條件或;

- () ——組成單元 如果字符串本身有括號"[(] aaa. [)]" ;

方法

|

1

2

3

4

|

//參數正則字符串,返回值*Regexpstr := regexp.MustCompile(string) //參數要查找的數據,查找次數-1為全局,返回值二維數組,查找出的字符串+正則字符串var result [][]string = str.FindAllStringSubmatch(data, -1) |

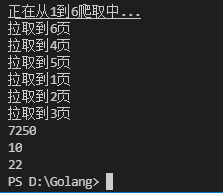

爬蟲

爬取博客園所有文章閱讀量,評論,推薦;

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

|

package mainimport ( "fmt" "io" "net/http" "regexp" "strconv")var readCount int = 0var commentCount int = 0var diggCount int = 0//http讀取網頁數據寫入result返回func HttpGet(url string) (result string, err error) { resp, err1 := http.Get(url) if err1 != nil { err = err1 return } defer resp.Body.Close() buf := make([]byte, 4096) for { n, err2 := resp.Body.Read(buf) //fmt.Println(url) if n == 0 { break } if err2 != nil && err2 != io.EOF { err = err2 return } result += string(buf[:n]) } return result, err}//橫向縱向爬取文章標題數據,并累計數值func SpiderPageDB(index int, page chan int) { url := "https://www.cnblogs.com/littleperilla/default.html?page=" + strconv.Itoa(index) result, err := HttpGet(url) if err != nil { fmt.Println("HttpGet err:", err) return } str := regexp.MustCompile("post-view-count\">閱讀[(](?s:(.*?))[)]</span>") alls := str.FindAllStringSubmatch(result, -1) for _, j := range alls { temp, err := strconv.Atoi(j[1]) if err != nil { fmt.Println("string2int err:", err) } readCount += temp } str = regexp.MustCompile("post-comment-count\">評論[(](?s:(.*?))[)]</span>") alls = str.FindAllStringSubmatch(result, -1) for _, j := range alls { temp, err := strconv.Atoi(j[1]) if err != nil { fmt.Println("string2int err:", err) } commentCount += temp } str = regexp.MustCompile("post-digg-count\">推薦[(](?s:(.*?))[)]</span>") alls = str.FindAllStringSubmatch(result, -1) for _, j := range alls { temp, err := strconv.Atoi(j[1]) if err != nil { fmt.Println("string2int err:", err) } diggCount += temp } page <- index}//主要工作方法func working(start, end int) { fmt.Printf("正在從%d到%d爬取中...\n", start, end) //channel通知主線程是否所有go都結束 page := make(chan int) //多線程go程同時爬取 for i := start; i <= end; i++ { go SpiderPageDB(i, page) } for i := start; i <= end; i++ { fmt.Printf("拉取到%d頁\n", <-page) }}//入口函數func main() { //輸入爬取的起始頁 var start, end int fmt.Print("startPos:") fmt.Scan(&start) fmt.Print("endPos:") fmt.Scan(&end) working(start, end) fmt.Println("閱讀:", readCount) fmt.Println("評論:", commentCount) fmt.Println("推薦:", diggCount)} |

補充:正則表達式加golang爬蟲爬取經典案例豆瓣top250

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

|

package mainimport ( "fmt" "io" "net/http" "os" "regexp" "strconv")func savToFile(index int, filmName, filmScore [][]string) { f, err := os.Create("第" + strconv.Itoa(index) + "頁.txt") if err != nil { fmt.Println("os create err", err) return } defer f.Close() // 查出有多少條 n := len(filmName) // 先寫抬頭 名稱 評分 f.WriteString("電影名稱" + "\t\t\t" + "評分" + "\n") for i := 0; i < n; i++ { f.WriteString(filmName[i][1] + "\t\t\t" + filmScore[i][1] + "\n") }}func main() { var start, end int fmt.Print("請輸入要爬取的起始頁") fmt.Scan(&start) fmt.Print("請輸入要爬取的終止頁") fmt.Scan(&end) working(start, end)}func working(start int, end int) { fmt.Printf("正在爬取%d到%d頁", start, end) for i := start; i <= end; i++ { SpiderPage(i) }}// 爬取一個豆瓣頁面數據信息保存到文檔func SpiderPage(index int) { // 獲取url url := "https://movie.douban.com/top250?start=" + strconv.Itoa((index-1)*25) + "&filter=" // 爬取url對應頁面 result, err := HttpGet(url) if err != nil { fmt.Println("httpget err", err) return } //fmt.Println("result=", result) // 解析,編譯正則表達式 ---電影名稱 ret := regexp.MustCompile(`<img width="100" id="codetool">

到此這篇關于Golang爬蟲及正則表達式的實現示例的文章就介紹到這了,更多相關Golang爬蟲及正則表達式 內容請搜索服務器之家以前的文章或繼續瀏覽下面的相關文章希望大家以后多多支持服務器之家! 原文鏈接:https://www.cnblogs.com/littleperilla/p/15721635.html 延伸 · 閱讀

精彩推薦

|